En el campo de la teledetección, el desenfoque del movimiento de imágenes es un desafío recurrente que dificulta la obtención de resultados precisos y de alta calidad. Para abordar este problema, los investigadores han trabajado en el desarrollo de mecanismos de aprendizaje multitarea que permitan corregir el desenfoque y mejorar la calidad de las imágenes obtenidas. En este artículo, exploraremos en detalle este interesante enfoque y analizaremos cómo puede beneficiar a la comunidad de la teledetección. ¡Descubramos juntos el mecanismo de aprendizaje multitarea para el desenfoque del movimiento de imágenes en teledetección!

Akash S (de la Facultad de Ingeniería de Karpagam) presentó un proyecto de último año sobre “Mecanismo de aprendizaje multitarea para el desenfoque de movimiento de imágenes en teledetección” a extrudesign.com.

ABSTRACTO

Obviamente, las imágenes de verificación de fotones se pueden utilizar para crear escenas limitadas por fotones. En las imágenes de verificación de fotones, la información sobre los fotones de eventos se captura como bordes duales (carcasas de planos de bits), que se convierten en una imagen de varios dígitos en el ciclo de propagación. En esta colaboración, es crucial aplicar un método de desenfoque para permitir la captura de escenas dinámicas sin oscuridad del desarrollo. Este artículo propone una estrategia de desenfoque para una modificación excepcional del embalaje a nivel de piezas de escenas dinámicas. El método propuesto implica difuminar unidades de evolución de elementos dentro de una escena mediante el uso de compensación de evolución para píxeles con evoluciones comparables. Esta técnica logra un desarrollo más útil del camuflaje oscuro que la desactivación directa de bloques de píxeles o unidades de área espacial. Además, se aplica una metodología original para una evaluación precisa del desarrollo de envases a nivel de piezas incluso en condiciones de fotones limitados mediante la evaluación realista del espectro transitorio de la velocidad de los fotones. Nuestros resultados exploratorios también mostraron que la estrategia propuesta se puede aplicar no solo para eliminar el desenfoque sino también para reducir el ruido, aumentando la distancia entre la señal cenital y la agitación en 1,2 dB. En resumen, el método de generación de planos de bits propuesto logra imágenes increíbles incluso en escenas especiales limitadas por fotones.

INTRODUCCIÓN DETECCIÓN REMOTA DESNEGRO DE IMAGEN-MOVIMIENTO

Un mayor desarrollo de estrategias para capturar excelentes imágenes en condiciones de fotones limitados sería útil en varias áreas, incluidas la medicina, la seguridad y la ciencia. En comparación con un sensor de imagen semiconductor de óxido metálico integrado (CMOS), que se utiliza principalmente recientemente, los dispositivos de imagen con detección de fotón único, como los sensores de diodo deslizante torrencial de fotón único (SPAD) y los sensores de imagen cuánticos (QIS), ofrecen enormes ventajas. ventajas en términos de alta capacidad de respuesta y orientación transitoria en condiciones de imágenes limitadas por fotones. Dichos dispositivos de imágenes también podrían usarse para una aplicación de imágenes de un cliente. Los dispositivos de inteligencia de fotones procesan los datos contenidos en los fotones que se producen como envolturas dobles (planos de bits) con valores de píxeles paralelos que determinan si los fotones se identifican o no. Las imágenes de varios bits se pueden modificar a partir de grandes conjuntos de fotogramas de plano puntual (por ejemplo, 256 aristas) aplicando sumas transitorias y espaciales básicas o estrategias de reproducción factual. Otra ventaja de las imágenes por conteo de fotones es la capacidad de seleccionar la estrategia de recuperación según la aplicación. También se consideran eficazmente estrategias de reproducción de imágenes para recuperar imágenes multibit de alta calidad a partir de bordes de plano de bits. En tales estrategias, ampliar el número de recintos de plano puntual a lo largo del tiempo mejora ampliamente la calidad de la imagen multibit restaurada al mejorar la relación señal-movimiento (SNR) de la imagen. Sin embargo, al capturar objetos en movimiento, es probable que las imágenes recién creadas que vienen con grandes cantidades de bordes del plano táctil experimenten desenfoque de movimiento. Esta ambigüedad de movimiento se produce debido a la coordinación de muchos bordes del plano de la pieza con diferentes posiciones en comparación con el movimiento de la pieza en cada borde. Esto sucede independientemente de si cada pieza del borde del avión está capturada con un objetivo mundano y no oculta ningún movimiento. En esta revisión, nuestro objetivo era desarrollar una técnica para recrear imágenes multibit en las que las complejidades de los elementos deberían ser claramente visibles incluso en escenas con restricciones de fotones. Para ello proponemos una técnica de reproducción de imágenes a partir de piezas originales que aplica el desenfoque.

Los objetivos de este estudio se pueden resumir de la siguiente manera: Se propone un método de evaluación del movimiento basado en una envolvente a nivel de pieza, en el que se aplica la evaluación factual de fotones episódicos. Para lograr un excelente desenfoque de bordes a nivel de pieza, es importante estimar con precisión el movimiento de los elementos en movimiento en una escena. Esta estrategia se puede utilizar para estimar con precisión el movimiento directamente a partir de una disposición general de los bordes del plano puntual con miras a evaluar el número transitorio de fotones episódicos. Nuestros resultados exploratorios muestran que el método de evaluación de movimiento propuesto es más preciso que las estrategias más simples que evalúan implícitamente el movimiento haciendo coincidir algunos contornos de varios bits modificados por los bordes del plano de bits. El método de evaluación de movimiento propuesto logró resultados de evaluación con errores de menos de 1 píxel, incluso en circunstancias limitadas por fotones con una tasa total de fotones de 0,1. Se propone una estrategia para eliminar el desenfoque de los recintos de planos de bits en términos de compensación de movimiento en unidades de «movimiento de elementos». Presentamos “imágenes algo borrosas” en las que se suprime el desenfoque de movimiento en ubicaciones incompletas que contienen los píxeles dentro de una escena que exhiben un movimiento explícito similar. Estas imágenes parcialmente borrosas se crean a partir de bordes de planos de bits y se utilizan para guiar la reproducción de imágenes. Nuestros resultados de reproducción muestran que las imágenes borrosas se pueden utilizar hasta cierto punto para oscurecer el movimiento. En las escenas de recreación, la estrategia de desenfoque propuesta tenía la posibilidad de aumentar la SNR máxima (PSNR) entre 0,2 y 0,9 dB, en contraste con las consecuencias de enfoques simples de desenfoque sin el uso de imágenes ligeramente borrosas. Además, presentamos una reproducción avanzada de imágenes parcialmente desenfocadas, que se puede utilizar tanto para eliminar ruido como para desactivarla. En comparación con la situación en la que solo se realizó desenfoque, se logró una mejora de 1,2 dB en PSNR. Nuestros resultados muestran que, hasta cierto punto, las imágenes borrosas son adecuadas para capturar escenas premium con limitación de fotones.

CREACIÓN DE IMAGEN DE UNA SOLA FOTO

Los fotones individuales son fuentes de luz que transmiten luz como partículas o fotones individuales. Se sitúan claramente entre fuentes de luz racionales (láseres) y fuentes de luz cálida como, por ejemplo, luces brillantes. El Estándar de Vulnerabilidad de Heisenberg establece que no se puede crear un estado con un número exacto de fotones de una sola repetición. En cualquier caso, los estados de Fock (o estados numéricos) se pueden leer para un cuadro en el que se distribuye suficiente intensidad de campo eléctrico en una velocidad de transmisión estrecha. En este caso único, una fuente de un solo fotón da como resultado un estado numérico de un solo fotón. Los fotones de una fuente ideal de fotón único exhiben propiedades de mecánica cuántica. Estas propiedades incluyen la antiagrupación de fotones, por lo que el tiempo entre dos fotones que viajan no es exactamente un valor de referencia. Esto a menudo se demuestra utilizando un divisor de columnas para coordinar la mitad de los fotones que ocurren con un fotodiodo deslizante portador de corriente y la otra mitad con un segundo. Las pulsaciones de un indicador se utilizan para dar una señal de «inicio del contador» a un reloj electrónico rápido, y el otro, compensado por un número conocido de nanosegundos, se utiliza para dar una señal de «parada del contador». Al estimar repetidamente los tiempos entre las señales de «inicio» y «parada», se puede construir un histograma del retardo de tiempo entre dos fotones y el número aleatorio; en el caso de que no se produzca empaquetamiento y los fotones sean indudablemente muy grandes, se divide, se Alrededor del aplazamiento cero se puede ver una sangría inconfundible.

RECONSTRUCCIÓN DE IMAGEN

La reconstrucción de imágenes en TC es un ciclo numérico que crea imágenes tomográficas a partir de información de proyección de rayos X recopilada en una variedad de puntos alrededor del paciente. La reproducción de imágenes afecta fundamentalmente a la calidad de la imagen y, con ello, a la proporción de radiación. Para un nivel de radiación determinado, resulta tentador recrear imágenes con la menor distorsión posible sin sacrificar la precisión de la imagen y la orientación espacial. Las reproducciones que mejoran aún más la calidad de la imagen se pueden convertir en una reducción del contenido de radiación, ya que se pueden recrear imágenes de calidad similar con una dosis menor. Hay dos clasificaciones principales de estrategias de rehacer: rehacer científico y reproducción iterativa (IR). ¿Y si nos centramos desde el principio en las técnicas de reproducción lógica? Hay muchos tipos de estrategias de remake lógico. Las estrategias de reconstrucción lógica más utilizadas en los escáneres de TC comerciales son todas la retroproyección separada (FBP), que utiliza un canal 1D en la información de proyección antes de que la información se retroproyecte en el espacio de la imagen (2D o 3D). La ubicuidad de la técnica FBP es esencialmente un resultado directo de su efectividad computacional y fortaleza matemática. Se han desarrollado varias estrategias de reproducción detalladas similares a FBP para diferentes épocas de la computación de recuperación de información por TC, desde la TC 2D igual y en forma de abanico en los años 1970 y 1980 hasta la TC en espiral y de cortes múltiples con participación limitada del visor a finales de los años 1990 y mediados de los años 1980. Década de 1990 Década de 1990. Años 2000 y TC multicorte con amplia inclusión de identificadores (hasta 320 columnas indicadoras y 16 cm de ancho).

ESTIMACIÓN DE MOVIMIENTO

La puntuación de movimiento es el método más común para determinar los vectores de movimiento que representan el cambio, comenzando con una imagen 2D y luego pasando a la siguiente; normalmente desde recintos adyacentes en una secuencia de vídeo. No es un tema bien interpretado porque el movimiento es en tres aspectos, pero las imágenes son una proyección de la escena 3D sobre un plano 2D. Los vectores de movimiento pueden referirse a la imagen completa (puntuación de movimiento global) o a partes explícitas, como cuadrados rectangulares, fijaciones de forma subjetiva o incluso por píxel. Los vectores de movimiento pueden abordarse mediante un modelo de traducción o varios otros modelos que pueden influir aproximadamente en el movimiento de una videocámara real, p. B. Rotación e interpretación en los tres aspectos y zoom. Por regla general, los términos evaluación del movimiento y el término corriente óptica se utilizan recíprocamente. También está relacionado conceptualmente con el registro de imágenes y la correspondencia del sistema de audio. De hecho, estos términos se refieren a la forma más común de observar las relaciones entre dos imágenes o esquemas de vídeo. Los focos que se comparan en dos perspectivas (imágenes o bordes) de una escena o artículo real son “normalmente” el punto exacto de esa escena o artículo. Antes de comenzar realmente a evaluar el movimiento, debemos caracterizar nuestra estimación de correspondencia, es decir, la medida de correspondencia, que es una estimación de cuán comparables son dos puntos focales de una imagen. Aquí nada está escrito en piedra; La decisión sobre la medición adecuada generalmente depende de para qué se utiliza el movimiento puntuado más recientemente y del método de mejora en la interacción de puntuación. Las técnicas de revés utilizan aspectos destacados como las posiciones de las esquinas y comparan aspectos destacados entre líneas, generalmente con una experiencia aplicada a un vecindario o área mundial. La motivación detrás de la capacidad mensurable es eliminar coincidencias que no tienen nada que ver con el movimiento real. RANSAC es una de las capacidades estadísticas utilizadas eficazmente. Es justo decir que prácticamente todas las estrategias requieren algún tipo de importancia para las reglas de comparación. Lo que importa es si primero suma un área de imagen local y luego piensa en resumir (por ejemplo, usando técnicas integradoras), o si primero analiza cada píxel (por ejemplo, elevando la diferencia al cuadrado) y luego suma un área de imagen cercana (basada en bloques). movimiento y movimiento basado en canales). Un nuevo tipo de estándar de coincidencia primero resume una región de imagen local para cada región de píxeles (mediante un cambio de elemento, como un cambio de Laplace), analiza cada píxel sumado y suma nuevamente en una región de imagen adyacente. Algunos estándares de coincidencia pueden prevenir focos que no están realmente relacionados entre sí al crear una buena puntuación de coincidencia. Otros no tienen esta capacidad pero siguen siendo modelos coincidentes.

Supresión de desenfoque de movimiento

Por favor habilite JavaScript

La ambigüedad del movimiento es la formación de bandas claras de elementos en movimiento en una fotografía o una secuencia de bordes, como por ejemplo. B. una película o una animación. Esto ocurre cuando la imagen capturada cambia durante la captura de un franco solitario debido a un desarrollo rápido o un franco largo. Cada vez que una cámara toma una fotografía, esa imagen no aborda un solo momento en el tiempo. Debido a limitaciones innovadoras o necesidades creativas, la imagen puede interactuar con la escena durante un período de tiempo prolongado. La mayoría de las veces, este tiempo abierto es tan corto que la imagen captada por la cámara parece capturar un breve momento. Sin embargo, este no suele ser el caso, y un artículo breve o un período prolongado de apertura pueden dar como resultado curiosidades poco claras que lo ilustren. Así como los objetos se mueven en una escena, una imagen de esa escena debe tener en cuenta la coordinación de las ubicaciones de todos esos objetos, así como la perspectiva de la cámara, ya que las horas extras no se compensan completamente con la velocidad de las sombras. En una imagen de este tipo, cualquier objeto que se mueva hacia la cámara aparecerá oscurecido o extendido a medida que avanza el movimiento relativo. Esta propagación puede ocurrir sobre un objeto en movimiento o sobre una superficie estática, siempre que la cámara esté en movimiento. Esto parece normal en una imagen de cine o televisión porque el ojo natural se comporta de manera similar.

IMÁGENES CON POCA LUZ

Capturar excelentes imágenes de sombras en condiciones de poca luz es un desafío difícil en la visión de PC. Las imágenes capturadas con cámaras de objetos suelen estar subexpuestas y son extremadamente llamativas. En este artículo, planeamos un marco de cámara híbrido que combine las ventajas de sensores de imagen rápidos, de alto objetivo y de rango completo para abordar este problema. Incluye varias cámaras monocromáticas de alto objetivo (HR-M), una cámara monocromática de alto objetivo (HS-M) y una única cámara de sonido de alto objetivo (HR-C). Para recuperar las imágenes magníficamente sombreadas, desarrollamos un cálculo de progreso de transformación original para eliminar el ruido del sensor HS-M y luego medimos los datos de movimiento de las secuencias de imágenes sin ruido para una deconvolución no ciega de la cámara HR-C. Primero realizamos una comparación directa de correcciones entre los conjuntos de imágenes HR-M y las imágenes HS-M, y luego usamos estos arreglos previos y un término de variedad absoluta ℓ1 para ajustar la capacidad real de eliminación de ruido de la imagen. Nuestra investigación tanto de imágenes fabricadas como originales muestra que nuestro marco es poderoso y sólido. Las imágenes con poca luz son una innovación diseñada para mejorar aún más la transmitancia en condiciones de poca luz. Las imágenes con poca luz, las imágenes cálidas y la iluminación del infrarrojo cercano son las tres mejoras de visión nocturna más utilizadas.

TRABAJO RELACIONADO

La obtención de imágenes con recuento de fotones se logra aprovechando la innovación del dispositivo de localizar la aparición de fotones individuales y una estrategia de representación de imágenes que convierte los datos de detección de fotones registrados como bordes paralelos en una imagen de varios bits. En esta parte, presentamos primero un dispositivo de imágenes desarrollado recientemente adecuado para un sitio de fotón único que permite el recuento de fotones. También se presenta el contraste entre las imágenes con recuento de fotones y las imágenes tradicionales con un sensor de imagen CMOS. A continuación se presentan las técnicas de juego habituales para convertir un borde doble en una imagen de varios bits. Se aclara el estándar de reproducción de imágenes mensurable, que es el requisito previo para la reproducción. Además, se presentan técnicas convencionales de representación de imágenes para escenas dinámicas con objetos en movimiento.

Mahoma. Al-Rawhani, James Beeley et al. han propuesto en este proyecto que las imágenes de fluorescencia (FI) son una estrategia poderosa en la ciencia y la medicina clínica. Los dispositivos de FI actuales utilizados para estudios in vivo o in vitro son costosos, voluminosos y consumen mucha energía, lo que limita el proceso a centros de investigación y salas de diagnóstico clínico. Aquí presentamos un contenedor de endoscopio de fluorescencia remoto de bajo consumo y reducido, que lo prepara para futuros marcos y aplicaciones de FI. Con una capacidad de respuesta mejorada en comparación con las innovaciones existentes, hemos demostrado que el paquete se puede utilizar de manera efectiva para obtener imágenes de la autofluorescencia del tejido y la fluorescencia deseada mediante el etiquetado de tejidos con fluoróforos. El contenedor combina un grupo de imágenes de indicador de fotón único semiconductor correlativo de óxido metálico de clase mundial, aislamiento óptico reducido, innovación remota y un plan de ahorro de energía. Durante el funcionamiento, el contenedor sólo consume 30,9 mW y emite una luz extremadamente débil de 468 nm. El dispositivo puede reemplazar la necesidad de endoscopios de fibra óptica de alto rendimiento y ampliar el alcance del examen clínico debajo del duodeno. Para ilustrar la presentación de nuestro caso, hemos fotografiado fantasmas fluorescentes que fusionan los principales fluoróforos del tejido (flavinas) y sustancias protectoras (hemoglobina). Además, demostramos la utilidad de la detección de discriminación de etiquetas mediante imágenes de una matriz de etiquetado de isotiocianato de fluoresceína (FITC) de 20 μM en tejido de mamífero. La endoscopia con luz blanca (WLE) ha sido durante mucho tiempo un método estándar para detectar patologías anormales en las partes superior e inferior del tracto gastrointestinal (GI). Sin embargo, no hace mucho, el interior era un área oscura que requería una defensa intrusiva para resolverla y abordarla. Esto cambió tras la aprobación de la endoscopia en contenedor (CE) para uso clínico por parte de la Administración de Medicamentos y Alimentos de EE. UU. (FDA) en 20013,4. Al igual que WLE, la CE utiliza imágenes de luz blanca (WLI) y puede ser adecuada para estudiar enfermedades como el cáncer, el drenaje gastrointestinal oscuro y la enfermedad de Crohn del intestino delgado3,5,6. En cualquier caso, tanto WLE como CE sufren los efectos negativos de una baja tasa de detección. Esta desventaja se ha eliminado para el tracto gastrointestinal superior y el duodeno mediante la introducción de la endoscopia por imágenes multimodal que utiliza WLI, imágenes por fluorescencia (FI) e imágenes de banda estrecha (NBI) en la combinación para aumentar la tasa de localización general del 53 % al 90% para aumentar. 2.7-9. También se están investigando nuevas estrategias para mejorar las tasas de identificación en la parte inferior del gráfico GI mediante la manipulación de la programación y la visualización en 3D de vídeos WLI grabados. También se examinan los avances mecánicos para controlar la posición de la caída y así mejorar la capacidad de demostración y recuperación10-12. En esta revisión, nos centramos en las imágenes de fluorescencia como un método que ofrece una increíble garantía de asociación con la endoscopia de contenedor de intestino delgado estándar actual.

Ivan Michel Antolovic, Samuel Burr et al. han propuesto en este proyecto que actualmente se utilizan generadores de imágenes sCMOS (en lugar de generadores de imágenes EMCCD) para aumentar la velocidad en la microscopía de confinamiento de superobjetivo. Los generadores de imágenes de diodo deslizante torrencial de fotón único (SPAD) tienen velocidades de fotogramas por profundidad de bit iguales o mayores que los generadores de imágenes sCMOS y, al mismo tiempo, producen fotogramas de microsegundos de 1 bit sin interferencia de lectura, lo que permite realizar un análisis de imágenes cronometrado de arriba hacia abajo. También se pueden utilizar objetivos de planificación elevados para estudiar el parpadeo del color fluorescente y otras propiedades fotofísicas que se pueden utilizar para mejorar el color. Presentamos el procedimiento para el examen de parpadeo de colores fluorescentes según la información de la prueba. Además, el nuevo uso de microlentes ha llevado a un aumento significativo en la capacidad de respuesta general del generador de imágenes SPAD (superposición de 12 veces en nuestro caso), lo que resulta en cualidades agradables para aplicaciones básicas de sensibilización. Esto nos permitió registrar los resultados clave de la microscopía de confinamiento de superobjetivo obtenidos utilizando un generador de imágenes SPAD con una sensibilidad de restricción de 20 nm y un objetivo de 80 nm. Abbe y Rayleigh caracterizaron y planificaron una resolución óptica limitada por difracción1. Se han desarrollado algunos métodos para superar el límite de Abbe2, por ejemplo, el agotamiento del estado fundamental y el retorno de un solo átomo (GSDIM3, también llamado dSTORM4), una estrategia de microscopía de confinamiento de superobjetivo de una sola partícula (SMLM) dadas las condiciones de encendido y apagado de las partículas fluorescentes. Los fluoróforos adheridos a patrones orgánicos se insertan en las almohadillas, lo que provoca oxidación y degradación y provoca un parpadeo estocástico. Los puntos focales de las capacidades de propagación puntual (PSF) son individuales, no están completamente ubicados en un contorno de imagen, con una pequeña cantidad de fluoróforos que emiten fotones. Al representar estas emanaciones de esta manera, emerge una imagen puntillista muy clara3. Las estrategias de comparación se basan en una pequeña cantidad de fluoróforos emisores por línea. Por ejemplo, también se puede utilizar microscopía de confinamiento fotográfico (PALM, que utiliza activación controlada por láser de fluoróforos de transferencia) o microscopía de regeneración óptica estocástica (STORM).

Algunos han considerado que los generadores de imágenes SPAD son inaceptables para aplicaciones donde la capacidad de respuesta es fundamental. Esta creencia fue impulsada por la falta de sensores de alto factor de llenado.

TRABAJO PROPUESTO

Proponemos una técnica inteligente de reproducción de imágenes basada en carcasas a nivel de piezas, la TRANSFORMACIÓN DE ONDAS DISCRETAS DOS DIMENSIONALES (DWT), en la que se aplica el desenfoque. El método de evaluación de movimiento propuesto logró resultados de evaluación con errores de menos de 1 píxel, incluso para fotones.

Circunstancias limitadas con una frecuencia de fotones de, en términos generales. Además, proponemos un método inmediato y preciso para la evaluación del movimiento basado en bordes del plano de la pieza. En nuestra estrategia, no existe ninguna razón convincente para determinar la ubicación de cada elemento individual, lo que permite ocultar el movimiento en una amplia gama de escenas. El marco propuesto promueve una estrategia para remodelar imágenes multibit donde las complejidades de los elementos deberían ser claramente visibles incluso en escenas con restricciones de fotones.

ESTIMACIÓN DE MOVIMIENTO

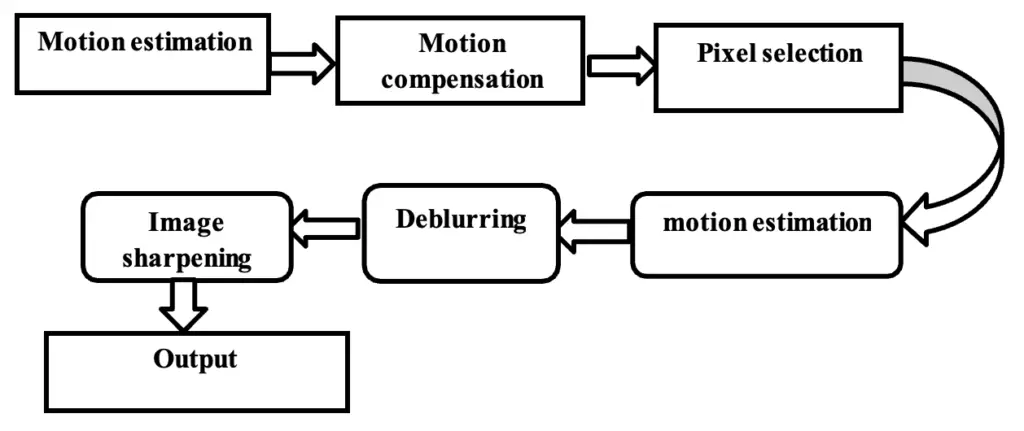

En esta sección, dada la diversidad volátil del número de fotones episódicos, proponemos un método inteligente para evaluar el movimiento de los bordes del plano de bits. Muestra la técnica propuesta para evaluar el movimiento de imágenes del plano táctil. En los píxeles (x; y) de una partícula en movimiento, las probabilidades de frecuencia de los fotones cambian después de un tiempo porque el movimiento del objeto cambia la incidencia de la luz después de un tiempo. Posteriormente, el número total de fotones que ocurren cambia en una secuencia doble que codifica la posición de todos los píxeles (x; y) del plano del ciclo T, como se muestra en la Fig. 3 (i). Con esta variedad es posible detectar los movimientos posicionales de los píxeles que siguen la evolución del elemento que se está visualizando. Dado que el movimiento del artículo es menor en comparación con estos píxeles, después de un tiempo experimentarán solo cambios menores en el número de fotones del episodio. Utilizando esta directriz, la estrategia propuesta mide el movimiento en una dirección ligeramente en el plano que limita la variación temporal en el número de fotones del episodio.

Mover las ubicaciones de cada borde del plano de la pieza. A continuación, la puntuación de movimiento propuesta se amplía para medir el movimiento del artículo con valores de consideración en el mapa α que se actualiza más de una vez durante cada ciclo de resaltado. En la técnica propuesta, α x,y, la puntuación de visualización en el píxel (x, y), tiene un valor de 0 a 1, que controla la visualización general del píxel (x, y) en comparación con otros píxeles. Esta puntuación de movimiento basada en el razonamiento proporciona los movimientos individuales dentro de una imagen que se ajustan a los píxeles con la estimación de atención más alta. El conjunto de resultados de

COMPENSACIÓN DE MOVIMIENTO PARA ALINEAR MARCOS BITPLANE

Con ď se pueden compensar movimientos que quedan ocultos por la disposición de los bordes del plano de la pieza en el plano de alojamiento. Específicamente, el valor pareado de cada píxel (x,y) en el t-ésimo plano de bits se reemplaza por el valor paralelo del píxel (x_(t,ď)^’, y_(t,ď)^’) determinado por aplicando ď uso. La aplicación de este ciclo de reemplazo de valor doble a todos los píxeles de una imagen proporciona un número de movimiento que hace coincidir las posiciones de los píxeles con el movimiento d en la matriz de T cuadros sin fin dentro de cada área de la imagen. Utilizando los bordes ajustados del plano de la pieza, es posible producir una imagen ligeramente borrosa aplicando una estrategia básica de restauración de imagen teniendo en cuenta la puntuación de probabilidad más alta posible. Primero, se establece un valor inicial típico de α x,y = 1 para todos los píxeles en el mapa α, ya que cuando se ve uniformemente, un incentivo para desenfocar en el primer ciclo tiene la ventaja de suprimir los movimientos que son normales en toda la imagen. por ejemplo, movimiento de la cámara. Las ventajas de α x,y se actualizan de una manera que extiende sus propiedades en píxeles donde el movimiento aún no está claro. En cada ciclo, se detectan los píxeles cuyo desenfoque de movimiento se ha suprimido eficazmente mediante el uso de compensación de movimiento a nivel de borde, y sus valores α x,y se reducen para formar las partes superiores α x,y del miembro de la familia de diferentes píxeles. Específicamente, los píxeles sin desenfoque de movimiento se identifican determinando la fuerza del desenfoque de movimiento en cada píxel calculando X^2 (la variación temporal del número de fotones que ocurren) de acuerdo con el proceso del número de movimiento. En esta interacción, los píxeles cuyos valores X^2 determinados están por debajo de un valor umbral (th_2) se reconocen como desenfoque de movimiento efectivamente suprimido. El nuevo α x,y para el siguiente resaltado se determina restando (constante) de los picos α x,y actuales de los píxeles efectivamente suprimidos.

SELECCIÓN DE PÍXELES DE IMÁGENES PARCIALES PARA LAVADO TOTAL

Los N bordes de imágenes razonablemente borrosas se obtienen recalentando los procesos de puntuación de movimiento, pago de movimiento y actualización del mapa α descritos anteriormente N veces. Como resultado final, la estrategia propuesta produce una imagen resultante, R, en la que el desenfoque de movimiento se suprime por completo basándose en la determinación de píxeles de la serie de imágenes razonablemente borrosas. Específicamente, cada píxel (x; y) de R se recrea seleccionando el píxel con el movimiento oculto básico de la matriz de píxeles (x; y) en la matriz de imágenes parcialmente borrosas tal como se muestra. Los píxeles cuyas bases están oscurecidas en la matriz de imágenes razonablemente borrosas se determinan evaluando las partes superiores X_(x,y)^2 de los píxeles. Primero, los mapas X^2 se crean a partir de una serie de recintos de planos de piezas personalizados relacionados con cada imagen parcialmente borrosa usando .A

Se aplica un filtro espacial (por ejemplo, canal normal) a los X^2Maps para reducir las diferencias espaciales de X^2 causadas por la aleatoriedad del conjunto de fotones del episodio. Luego, cada píxel (x; y) de R se recrea seleccionando el píxel con la menor cantidad de X_(x,y)^2 de X^2Maps.

PRECISIÓN DE LA ESTIMACIÓN DEL MOVIMIENTO

El error de evaluación de movimiento de la estrategia propuesta se determinó y se comparó con el de un enfoque de evaluación de movimiento normal en el que el movimiento se evalúa de forma indirecta utilizando algunas imágenes multibit modificadas de todo el conjunto de recintos del plano puntual. La baja SNR y el enorme desenfoque de movimiento en imágenes multibit dificultan la evaluación precisa del movimiento utilizando métodos tradicionales como el propuesto. La figura anterior muestra la escena utilizada para la estimación de precisión, que contiene un objeto rectangular en movimiento de interpretación contra una base inamovible. Para evitar la influencia de la superficie del producto, tanto el producto como la imprimación tienen una iridiscencia uniforme. Para la evaluación se utilizó una suma de bordes planos de la escena de 256 bits. El área individual ideal del objeto que se mueve se utilizó como plantilla típica para las dos técnicas. La técnica propuesta estimó el movimiento en solo un pequeño rumbo al entrar al avión, limitando la cantidad de X^2 dentro del formato. Es bastante significativo que en esta evaluación no se tenga en cuenta la evaluación de movimiento propuesta (considerando un incentivo por cada píxel). Para investigar, también evaluamos la precisión de la técnica presentada utilizando σ^2 como costo de evaluación del movimiento. Para completar la evaluación de movimiento tradicional, se utilizaron dos imágenes multibit modificadas a partir de 256 bordes planos cíclicos. Cada imagen de múltiples bits se creó agregando carcasas de capas de 128 bits, y el movimiento se evaluó proporcionando un diseño basado en valores de píxeles que coincide con contornos discriminativos entre imágenes continuas de múltiples bits. En la técnica convencional, el número disponible de bordes de planos de pieza por imagen de múltiples bits estaba limitado por la necesidad de generar más de dos imágenes de múltiples bits a partir de la matriz general de paquetes de plano táctil para la coordinación de imágenes. La pobre SNR resultante para cada imagen multibit hizo difícil estimar el movimiento, especialmente cuando la cantidad de fotones del episodio era limitada. La técnica propuesta, por otro lado, evaluó el movimiento directamente desde toda la disposición del recinto del plano táctil sin utilizar imágenes multibit, lo que, como se muestra, resultó en un menor error de juicio. Sin embargo, suponiendo que usamos σ^2 como valor para la evaluación del movimiento, observar el movimiento esperado que limita la cantidad total de σ^2 aumentó el error porque la cantidad de fotones que ocurren en cada ubicación contrasta, lo cual se debe a los contrastes entre las luces. se deben al artículo en movimiento y a la fundación. En particular, los pequeños movimientos ascendentes esperados de σ^2 de las áreas de cimentación debido a la baja luminancia perjudicaron la evaluación del movimiento del objeto. Por el contrario, el uso de la estadística X^2 redujo la tasa de error dado que X^2 está libre de luminancia del elemento.

COMPARACIÓN DE RESULTADOS CON DESBORNAMIENTO

En el caso de que podamos obtener regiones espaciales ideales donde los píxeles experimentan un movimiento uniforme para cada elemento en movimiento, la eliminación detallada del desenfoque permite una ofuscación efectiva del movimiento con resultados de evaluación precisos. Sin embargo, hay zonas con múltiples movimientos en escenas originales, por ejemplo, donde un solo objeto sufre múltiples movimientos o hay otros objetos con diferentes movimientos de cobertura. En tales casos, el desenfoque de movimiento se puede limitar a un subconjunto de píxeles, mientras que el desenfoque de movimiento espacial se suprime en áreas enteras. Del mismo modo, las variaciones en la cantidad de fotones que ocurren por bloque conducen a errores en el juicio del movimiento y al deterioro de la calidad de la imagen debido a la dispersión del número de movimientos por bloque, mientras que el movimiento se oscurece espacialmente bloque por bloque para respaldar escenas desordenadas. Para superar estos problemas, la estrategia propuesta suprime el movimiento de una manera orientada al movimiento (es decir, entre conjuntos de píxeles con movimiento similar) mediante el uso de imágenes parcialmente borrosas. A diferencia de los métodos espaciales inteligentes, la estrategia propuesta puede manejar una escena en la que un objeto determinado experimenta numerosos movimientos o diferentes objetos en movimiento experimentan movimientos encubiertos. A diferencia de los métodos de bloques, la técnica propuesta puede suprimir el enmascaramiento de movimiento mediante una compensación de movimiento uniforme para píxeles con un movimiento similar mediante el uso de imágenes borrosas hasta cierto punto. Luego analizamos casos de resultados de reproducción de imágenes después de la ofuscación de movimiento utilizando los enfoques Square y District Savvy, así como el enfoque propuesto.

CONFIGURACIÓN EXPERIMENTAL

Este artículo propone un método para la evaluación del movimiento inmediato de toda la disposición del recinto del plano táctil y una técnica de desactivación en términos de compensación de movimiento en unidades de «movimiento del objeto». En esta sección, evaluamos la precisión de la evaluación del movimiento y el tipo de imágenes recién creadas de la técnica de desenfoque propuesta. Actualmente también hemos desarrollado aún más la reproducción de imágenes parcialmente desenfocadas, que se pueden utilizar tanto para eliminar el ruido como para desactivarlo. Bordes del plano de bits. Creamos bordes planos de piezas calculando la velocidad de los fotones en cada píxel usando una capacitancia irregular que sigue una apropiación de Poisson, y el contador de fotones cede por la misma razón.

En particular, al promediar las alturas de los píxeles en algunas imágenes algo borrosas, se logra la reducción de ruido mediante una ofuscación aleatoria en los recuentos de fotones de los episodios. Promediar los píxeles en algunas imágenes parcialmente borrosas permite ampliar el número de ejemplos de valores paralelos por píxel en una imagen resultante, ya que cada píxel de una imagen algo borrosa se obtiene a partir de píxeles en diferentes ubicaciones en la pieza de carcasa plana debido a los contrastes en la matriz. avión. A partir de estos resultados, se puede observar un patrón de disminución de la calidad del desenfoque a medida que aumenta la diferencia de velocidad entre elementos individuales. Sin embargo, esta degradación en la precisión también ocurre en otros enfoques de desenfoque, como los métodos de revelación espacial y en bloques, debido al error incremental de estimación del movimiento causado por el desarrollo del área de estudio para forzar el movimiento de elementos con mucho movimiento. Observamos que estos resultados solo muestran la precisión de la selección de píxeles para el caso excepcional de una escena en la que se mueven elementos de un píxel de ancho. Normalmente, el tamaño del elemento es mayor que un píxel, lo que aumenta el valor de X^2 y reduce la tasa de error en la determinación de píxeles independientemente de si el elemento se mueve rápidamente. En una escena con un elemento corto, probablemente habrá lugares con obstáculos donde el objeto en movimiento y su experiencia se cruzan en infinitos bordes del plano de la pieza. Debido a la mezcla de los movimientos de los dos objetos (el objeto gigante en movimiento y la base) a largo plazo, los píxeles en tales obstáculos a menudo tienen altos beneficios de X^2, independientemente de si el desenfoque de movimiento es compensado por el movimientos de los objetos o del fondo. Por lo tanto, es difícil reducir las ventajas α de los píxeles en la ubicación del obstáculo en la interacción de actualización de αMap. Las ventajas de que α permanezca alto durante todo el ciclo del centro de gravedad hacen que sea difícil trabajar en el enfoque de diferentes ubicaciones mediante la evaluación del movimiento basada en el razonamiento.

DIPLOMA

Propusimos una estrategia de desenfoque para imágenes de fotón único que utiliza «imágenes borrosas hasta cierto punto» para suprimir el movimiento en una escena en cuadrados de movimiento normal de píxeles. Nuestros resultados experimentales confirmaron que la estrategia propuesta puede suprimir el desenfoque de movimiento de manera más eficiente que las simples técnicas de eliminación de desenfoque en unidades de píxeles cuadrados o áreas de objetos espaciales. En las escenas de ocio, la técnica de desactivación propuesta ofrecía la posibilidad de ampliar el PSNR entre 0,2 y 0,9 dB, en contraste con enfoques de desactivación menos difíciles. La estrategia de evaluación de movimiento propuesta logró resultados de evaluación altamente precisos con un error de menos de 1 píxel, incluso en condiciones de fotones limitados con una frecuencia total de 0,1 fotones, debido a su capacidad para evaluar realmente la diversidad volátil de fotones que se produce. Además de eliminar el desenfoque, la estrategia propuesta también se puede aplicar a la eliminación de ruido. En comparación con la situación en la que solo se realizó desenfoque, se logró una mejora de 1,2 dB en PSNR. En esta prueba esperábamos una nueva versión de los casos Bitplane. Sería extremadamente útil capturar escenas dinámicas, como matrices de vídeo, y ampliar la estrategia propuesta para eliminar el desenfoque y el ruido de grupos de vídeo utilizando paquetes bitplane, lo que sería un enfoque productivo para trabajos futuros.

REFERENCIAS

- W. Ren, J. Contenedor, IEEE Int. Calcular conf. Vis. (ICCV), octubre de 2017, págs. 1077-1085.

- MA Al-Rawhani, J. Beeley y DRS Cumming, “Contenedor de fluorescencia inalámbrico para endoscopia mediante detección basada en fotón único”, Sci. Rep., Vol. 5, no. 1, págs. 1-9, noviembre de 2016.

- IM Antolovic, S. Burri, C. Bruschini, RA Hoebe y E. Charbon, “Los generadores de imágenes SPAD para microscopía de confinamiento de superobjetivo permiten el estudio del parpadeo rápido de los fluoróforos”, Sci. Rep., Vol. 7, no. 1, página 44108, abril de 2017.

- M. Perenzoni, D. Perenzoni y D. Stoppa, “Un sensor TOF directo fotomultiplicador de silicio de 64 × 64 píxeles controlado por computadora con descarga de base de 100 Mfotones/s/píxel y modo de imágenes/altímetro con una precisión del 0,14% hasta 6 km para.» Ruta y aterrizaje de naves espaciales», IEEE J. Strong State Circuits, vol. 52, N° 1, págs. 151-160, enero de 2017.

- NAW Dutton, L. Parmesan, AJ Holmes, LA Award y RK Henderson, “Sensor de imagen computarizado de conteo de fotones individuales sobremuestreado 320 × 240”, en Symp. VLSI Circuits Dig. Tecnología. Artículos, junio de 2014, págs. 1-2.

- J. Mama y ER Fossum, “Escritura del sensor de imagen Quanta con capacidad de conteo de fotones y conmoción de lectura inferior a 0,3 er.ms”, IEEE Electron Device Lett., vol. 36, núm. 9, págs. 926–928, septiembre de 2015.

- M. L. McHugh, “La prueba de libertad de chi-cuadrado”, Biochemia Medica, vol. 23, núm. 2, págs. 143-149, 2013.

- A. Gupta, A. Ingle y M. Gupta, “Imágenes 3D asincrónicas de fotón único”, en Proc. IEEE/CVF Int. Calcular conf. Vis. (ICCV), octubre de 2019, págs. 7909–7918.

- I. Gyongy, N. Dutton y R. Henderson, “Seguimiento de fotón único para visión de alta velocidad”, Sensors, vol. 18, núm. 2, página 323, enero de 2018.

- F. Yang, YM Lu, L. Sbaiz y M. Vetterli, “Bits de fotones: obtención de imágenes sobremuestreadas mediante mediciones de doble Poisson”, IEEE Trans. Image Processing, vol. 21, núm. 4, págs. 1421-1436, abril de 2012.

Crédito de la imagen: Este documento de proyecto “Mecanismo de aprendizaje multitarea para la eliminación del desenfoque del movimiento de imágenes por detección remota” fue presentado por Akash S de la Facultad de Ingeniería de Karpagam.

[automatic_youtube_gallery type=»search» search=»Mecanismo de aprendizaje multitarea para el desenfoque del movimiento de imágenes en teledetección

» limit=»1″]

«Mecanismo de aprendizaje de múltiples tareas para el desenfoque de imagen por movimiento en la teledetección»

Introducción al desenfoque de imagen por movimiento en la teledetección

El desarrollo de técnicas para obtener imágenes de alta calidad en condiciones de luz limitada sería beneficioso en diversos campos, como la medicina, la seguridad y la ciencia. Las imágenes obtenidas mediante la detección de fotones individuales son especialmente ventajosas en términos de su alta sensibilidad y resolución temporal en condiciones de teledetección con luz limitada. Estos dispositivos de imagen también podrían utilizarse en aplicaciones de imagen para consumidores. La detección de fotones individuales representa información contenida en los fotones incidentes como encuadres binarios (planos de bits) compuestos por valores de píxeles paralelos que indican si se detectan o no fotones. Se pueden generar imágenes de varios bits a partir de un gran número de planos de bits (por ejemplo, 256 planos) mediante sumas espaciales y temporales simples o mediante técnicas de simulación estadística. Una ventaja adicional de la imagen de conteo de fotones es la capacidad de elegir el método de reconstrucción en función de la aplicación. Actualmente se están investigando métodos de reconstrucción de imágenes de varios bits para obtener imágenes de alta calidad a partir de los planos de bits. Estos métodos mejoran generalmente la relación señal-ruido (SNR) de la imagen reconstruida a medida que se incrementa el número de planos de bits en la dirección temporal. Sin embargo, cuando se capturan objetos en movimiento, es probable que se produzca desenfoque de movimiento en las imágenes reconstruidas utilizando un gran número de planos de bits. Este desenfoque de movimiento se produce debido a la integración de varios planos de bits con diferentes posiciones en comparación con el movimiento del objeto en cada plano. Esto ocurre incluso si cada plano de bits capturado con una alta resolución temporal no tiene desenfoque de movimiento. En este estudio, nuestro objetivo fue desarrollar un método para reconstruir imágenes de varios bits en las que los detalles del objeto deben ser claramente visibles incluso en escenas con luz limitada. Con este fin, proponemos un método original de reconstrucción de imágenes basado en planos de bits en el que aplicamos el desenfoque de movimiento.

Las contribuciones de este estudio se pueden resumir de la siguiente manera:

1. Se propone un método de evaluación de movimiento basado en planos de bits en el que se aplica la evaluación estadística de los fotones incidentes. Para lograr una desenfoque de planos de bits de alta calidad, es necesario evaluar con precisión el movimiento de los objetos en movimiento en una escena. Este método se puede utilizar para medir con precisión el movimiento directamente a partir de un conjunto general de planos de bits en función de una evaluación de la variación temporal del número de fotones incidentes. Nuestros resultados experimentales muestran que el método propuesto de evaluación de movimiento es más preciso que los métodos más simples en los que el movimiento se evalúa indirectamente mediante la comparación de varios cuadros de varios bits generados a partir de planos de bits. El método de evaluación de movimiento propuesto logró resultados de evaluación con errores inferiores a 1 píxel, incluso en condiciones de luz limitada con una frecuencia de 0,1 fotones en general.

2. Se propone un método de desenfoque de plano de bits basado en la compensación de movimiento en unidades de «movimiento del objeto». Presentamos imágenes «parcialmente desenfocadas», en las que se suprime el desenfoque de movimiento en regiones parciales que contienen los píxeles dentro de una escena que tienen el mismo movimiento definido. Estas imágenes parcialmente desenfocadas se generan a partir de planos de bits y se utilizan para realizar la reconstrucción de imágenes. Nuestros resultados de simulación revelan que las imágenes parcialmente desenfocadas se pueden utilizar para suprimir eficazmente el desenfoque de movimiento. En las escenas de simulación, el método de desenfoque propuesto logró aumentar la relación señal-ruido máxima (PSNR) en 0,2-0,9 dB en comparación con los resultados de los enfoques de desenfoque simples sin utilizar imágenes parcialmente desenfocadas. Además, presentamos una simulación avanzada para imágenes parcialmente desenfocadas que se pueden aplicar tanto para el desenfoque como para la eliminación de ruido. Se logró una mejora en el PSNR de 1,2 dB en comparación con la situación en la que solo se realizó el desenfoque. Nuestros resultados muestran que las imágenes parcialmente desenfocadas son efectivas para capturar escenas de alta calidad con luz limitada.